고정 헤더 영역

상세 컨텐츠

본문

6. Service & AWS LoadBalancer Controller

[Kubernetest Service]

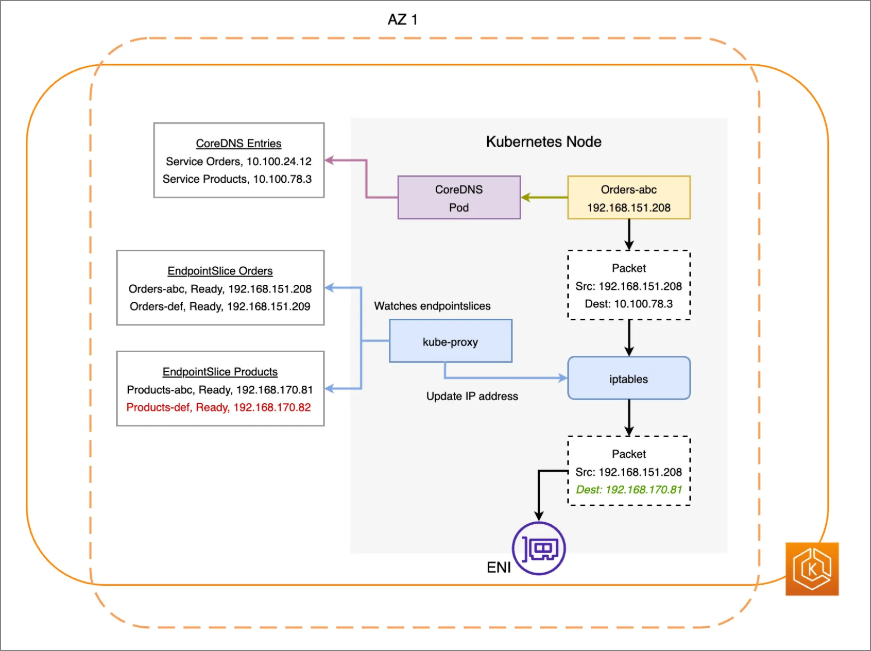

- 쿠버네티스 서비스 : pod는 언제나 순환(삭제 > 생성 > 삭제 ...)되며 IP가 변경되기 때문에 고정 IP 사용이 가능한 서비스가 생기게 되었다. 서비스는 고정 IP와 도메인 네임을 제공한다. 서비스는 부하 분산이 가능한다 (Iptables 룰로 처리)

[ Kubernetest Service 종류]

- Cluster IP : 쿠버네티스 클러스터 내부에서 서비스에 접속할 수 있지만 클러스터 외부에서는 ClusterIP 서비스로 접속할 수 없다.

- NodePort : 쿠버네티스 클러스터 외부에서 노드의 IP:NodePort로 접속할 수 있다. 노드는 기본적으로 쿠버네티스 클러스터의 모든 노드로 접속이 가능하고 NodePort는 Cluster IP 서비스를 포함하고 있다.

- LoadBalancer : Public 클라우드에서 제공하는 로드밸런서 서비스를 사용해 외부에서 쿠버네티스 클러스터로 접속할 수 있다. Loadbalancer 서비스는 NodePort와 ClusterIP 서비스를 포함하고 있다.

- ExternalName : ClusterIP, NodePort, LoadBalancer 서비스의 동작은 클라이언트가 서비스를 통해서 파드로 접속한다. 하지만 ExternalName 서비스는 쿠버네티스 클러스터 내부에서 서비스의 도메인으로 접속 시 CNAME 레코드를 리턴하여 접속한다.

[cloud controller Manager를 통해 K8S NodePort 정보를 사용하는 CLB/NLB 프로비저닝]

파드의 IP 알 필요가 없고 노드포트 정보만 알아오면 된다.

[Service (LoadBalancer Controller) : AWS Load Balancer Controller + NLB (파드) IP 모드 동작 with AWS VPC CNI]

IP모드 동작은 클라우드 컨트롤러에 있는 노드 포트의 정보 뿐만 아니라 pod의 ip도 알아야함 > LB contoller pod가 eks 클러스터를 통해 pod ip 정보를 받아와 LB로 정보를 업데이트 해줌

[NLB 모드 정리]

1) 인스턴스 유형 : 노드에 NodePort로 전달

2) IP 유형 : Pod IP가 필요하기 때문에 반드시 AWS Loadbalancer controller Pod 및 정책 설정이 필요

[실습]

- AWS LoadBalancer Controller 배포

# 설치 전 CRD 확인

kubectl get crd

# Helm Chart 설치

helm repo add eks https://aws.github.io/eks-charts

helm repo update

helm install aws-load-balancer-controller eks/aws-load-balancer-controller -n kube-system --set clusterName=$CLUSTER_NAME

## 설치 확인

kubectl get crd

kubectl explain ingressclassparams.elbv2.k8s.aws

kubectl explain targetgroupbindings.elbv2.k8s.aws

kubectl get deployment -n kube-system aws-load-balancer-controller

kubectl describe deploy -n kube-system aws-load-balancer-controller

kubectl describe deploy -n kube-system aws-load-balancer-controller | grep 'Service Account'

Service Account: aws-load-balancer-controller

# 클러스터롤, 롤 확인

kubectl describe clusterrolebindings.rbac.authorization.k8s.io aws-load-balancer-controller-rolebinding

kubectl describe clusterroles.rbac.authorization.k8s.io aws-load-balancer-controller-role

...

PolicyRule:

Resources Non-Resource URLs Resource Names Verbs

--------- ----------------- -------------- -----

targetgroupbindings.elbv2.k8s.aws [] [] [create delete get list patch update watch]

events [] [] [create patch]

ingresses [] [] [get list patch update watch]

services [] [] [get list patch update watch]

ingresses.extensions [] [] [get list patch update watch]

services.extensions [] [] [get list patch update watch]

ingresses.networking.k8s.io [] [] [get list patch update watch]

services.networking.k8s.io [] [] [get list patch update watch]

endpoints [] [] [get list watch]

namespaces [] [] [get list watch]

nodes [] [] [get list watch]

pods [] [] [get list watch]

endpointslices.discovery.k8s.io [] [] [get list watch]

ingressclassparams.elbv2.k8s.aws [] [] [get list watch]

ingressclasses.networking.k8s.io [] [] [get list watch]

ingresses/status [] [] [update patch]

pods/status [] [] [update patch]

services/status [] [] [update patch]

targetgroupbindings/status [] [] [update patch]

ingresses.elbv2.k8s.aws/status [] [] [update patch]

pods.elbv2.k8s.aws/status [] [] [update patch]

services.elbv2.k8s.aws/status [] [] [update patch]

targetgroupbindings.elbv2.k8s.aws/status [] [] [update patch]

ingresses.extensions/status [] [] [update patch]

pods.extensions/status [] [] [update patch]

services.extensions/status [] [] [update patch]

targetgroupbindings.extensions/status [] [] [update patch]

ingresses.networking.k8s.io/status [] [] [update patch]

pods.networking.k8s.io/status [] [] [update patch]

services.networking.k8s.io/status [] [] [update patch]

targetgroupbindings.networking.k8s.io/status [] [] [update patch]

- 서비스/파드 배포 테스트 with NLB

# 디플로이먼트 & 서비스 생성

cat << EOF > echo-service-nlb.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: deploy-echo

spec:

replicas: 2

selector:

matchLabels:

app: deploy-websrv

template:

metadata:

labels:

app: deploy-websrv

spec:

terminationGracePeriodSeconds: 0

containers:

- name: aews-websrv

image: k8s.gcr.io/echoserver:1.5

ports:

- containerPort: 8080

---

apiVersion: v1

kind: Service

metadata:

name: svc-nlb-ip-type

annotations:

service.beta.kubernetes.io/aws-load-balancer-nlb-target-type: ip

service.beta.kubernetes.io/aws-load-balancer-scheme: internet-facing

service.beta.kubernetes.io/aws-load-balancer-healthcheck-port: "8080"

service.beta.kubernetes.io/aws-load-balancer-cross-zone-load-balancing-enabled: "true"

spec:

ports:

- port: 80

targetPort: 8080

protocol: TCP

type: LoadBalancer

loadBalancerClass: service.k8s.aws/nlb

selector:

app: deploy-websrv

EOF

kubectl apply -f echo-service-nlb.yaml

# 확인

aws elbv2 describe-load-balancers --query 'LoadBalancers[*].State.Code' --output text

kubectl get deploy,pod

kubectl get svc,ep,ingressclassparams,targetgroupbindings

kubectl get targetgroupbindings -o json | jq

# AWS 관리콘솔에서 NLB 정보 확인

# 빠른 실습을 위해서 등록 취소 지연(드레이닝 간격) 수정 : 기본값 300초

echo-service-nlb.yaml 파일 IDE(VS code)에서 수정

..

apiVersion: v1

kind: Service

metadata:

name: svc-nlb-ip-type

annotations:

service.beta.kubernetes.io/aws-load-balancer-nlb-target-type: ip

service.beta.kubernetes.io/aws-load-balancer-scheme: internet-facing

service.beta.kubernetes.io/aws-load-balancer-healthcheck-port: "8080"

service.beta.kubernetes.io/aws-load-balancer-cross-zone-load-balancing-enabled: "true"

service.beta.kubernetes.io/aws-load-balancer-target-group-attributes: deregistration_delay.timeout_seconds=60

...

kubectl apply -f echo-service-nlb.yaml

yaml 파일 > annotaions에 service.beta.kubernetes.io/aws-load-balancer-target-group-attributes: deregistration_delay.timeout_seconds=60 추가

#웹 접속 주소

kubectl get svc svc-nlb-ip-type -o jsonpath='{.status.loadBalancer.ingress[0].hostname}' | awk '{ print "Pod Web URL = http://"$1 }'

Pod Web URL = http://k8s-default-svcnlbip-1844940e79-dea6c1fbe904f551.elb.ap-northeast-2.amazonaws.com

# 파드 로깅 모니터링

kubectl logs -l app=deploy-websrv -f

kubectl stern -l app=deploy-websrv

# 분산 접속 확인

NLB=$(kubectl get svc svc-nlb-ip-type -o jsonpath='{.status.loadBalancer.ingress[0].hostname}')

curl -s $NLB

for i in {1..100}; do curl -s $NLB | grep Hostname ; done | sort | uniq -c | sort -nr

54 Hostname: deploy-echo-bf9bdb8bc-dn6bl

46 Hostname: deploy-echo-bf9bdb8bc-5vslj

# 지속적인 접속 시도 : 아래 상세 동작 확인 시 유용(패킷 덤프 등)

while true; do curl -s --connect-timeout 1 $NLB | egrep 'Hostname|client_address'; echo "----------" ; date "+%Y-%m-%d %H:%M:%S" ; sleep 1; done

AWS VCP CNI는 경로 최적화에 유리하다!

replica 수를 늘려서 타겟 추가 확인

7. Ingress

내부의 서비스를 HTTP/HTTPS 통해 외부로 노출 - web Proxy 역할

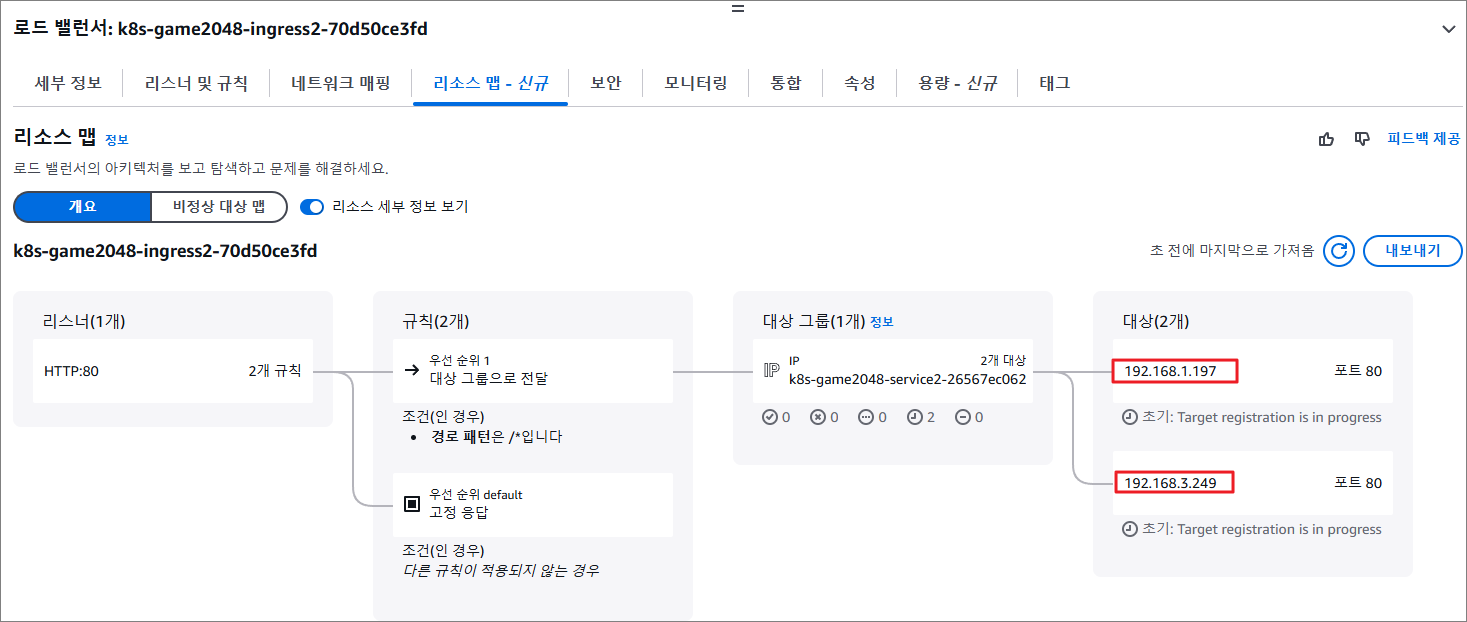

AWS Load Balancer Controller + Ingress (ALB) IP 모드 동작 with AWS VPC CNI

ALB IP 모드로 동작하기때문에 LB Controller Pod가 필요하다.

# 게임 파드와 Service, Ingress 배포

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Namespace

metadata:

name: game-2048

---

apiVersion: apps/v1

kind: Deployment

metadata:

namespace: game-2048

name: deployment-2048

spec:

selector:

matchLabels:

app.kubernetes.io/name: app-2048

replicas: 2

template:

metadata:

labels:

app.kubernetes.io/name: app-2048

spec:

containers:

- image: public.ecr.aws/l6m2t8p7/docker-2048:latest

imagePullPolicy: Always

name: app-2048

ports:

- containerPort: 80

---

apiVersion: v1

kind: Service

metadata:

namespace: game-2048

name: service-2048

spec:

ports:

- port: 80

targetPort: 80

protocol: TCP

type: NodePort

selector:

app.kubernetes.io/name: app-2048

---

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

namespace: game-2048

name: ingress-2048

annotations:

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/target-type: ip

spec:

ingressClassName: alb

rules:

- http:

paths:

- path: /

pathType: Prefix

backend:

service:

name: service-2048

port:

number: 80

EOF

# 모니터링

watch -d kubectl get pod,ingress,svc,ep,endpointslices -n game-2048

# 생성 확인

kubectl get ingress,svc,ep,pod -n game-2048

kubectl get-all -n game-2048

kubectl get targetgroupbindings -n game-2048

# ALB 생성 확인

aws elbv2 describe-load-balancers --query 'LoadBalancers[?contains(LoadBalancerName, `k8s-game2048`) == `true`]' | jq

ALB_ARN=$(aws elbv2 describe-load-balancers --query 'LoadBalancers[?contains(LoadBalancerName, `k8s-game2048`) == `true`].LoadBalancerArn' | jq -r '.[0]')

aws elbv2 describe-target-groups --load-balancer-arn $ALB_ARN

TARGET_GROUP_ARN=$(aws elbv2 describe-target-groups --load-balancer-arn $ALB_ARN | jq -r '.TargetGroups[0].TargetGroupArn')

aws elbv2 describe-target-health --target-group-arn $TARGET_GROUP_ARN | jq

# Ingress 확인

kubectl describe ingress -n game-2048 ingress-2048

kubectl get ingress -n game-2048 ingress-2048 -o jsonpath="{.status.loadBalancer.ingress[*].hostname}{'\n'}"

# 게임 접속 : ALB 주소로 웹 접속

kubectl get ingress -n game-2048 ingress-2048 -o jsonpath='{.status.loadBalancer.ingress[0].hostname}' | awk '{ print "Game URL = http://"$1 }'

# 파드 IP 확인

kubectl get pod -n game-2048 -owide

ALB에서 Pod IP로 직접 전달

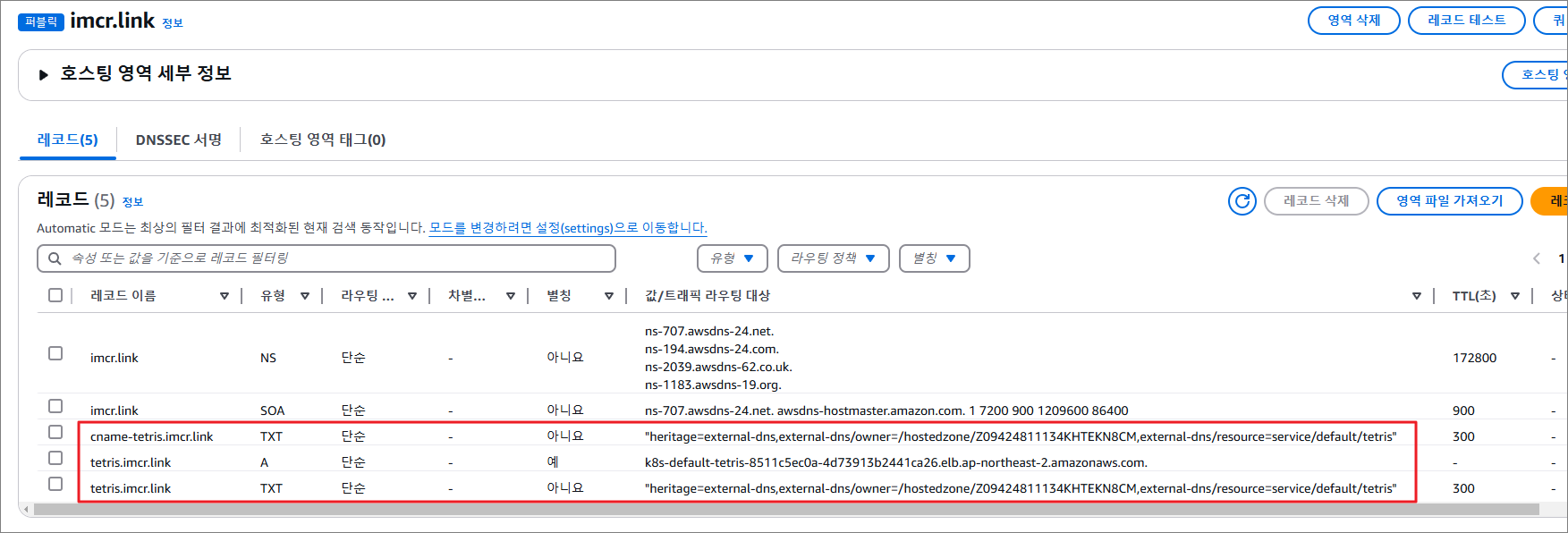

8. ExternalDNS

K8S 서비스/인그레스 생성 시 도메인을 설정하면 AWS Route53, Azure DNS, GCP cloudDNS에 A 레코드가 자동 생성/삭제

[실습]

- AWS Route53 정보 확인 및 변수 지정

MyDomain=<자신의 도메인>

# 자신의 Route 53 도메인 ID 조회 및 변수 지정

aws route53 list-hosted-zones-by-name --dns-name "${MyDomain}." | jq

aws route53 list-hosted-zones-by-name --dns-name "${MyDomain}." --query "HostedZones[0].Name"

aws route53 list-hosted-zones-by-name --dns-name "${MyDomain}." --query "HostedZones[0].Id" --output text

MyDnzHostedZoneId=`aws route53 list-hosted-zones-by-name --dns-name "${MyDomain}." --query "HostedZones[0].Id" --output text`

echo $MyDnzHostedZoneId

# (옵션) NS 레코드 타입 첫번째 조회

aws route53 list-resource-record-sets --output json --hosted-zone-id "${MyDnzHostedZoneId}" --query "ResourceRecordSets[?Type == 'NS']" | jq -r '.[0].ResourceRecords[].Value'

# (옵션) A 레코드 타입 모두 조회

aws route53 list-resource-record-sets --output json --hosted-zone-id "${MyDnzHostedZoneId}" --query "ResourceRecordSets[?Type == 'A']"

# A 레코드 타입 조회

aws route53 list-resource-record-sets --hosted-zone-id "${MyDnzHostedZoneId}" --query "ResourceRecordSets[?Type == 'A']" | jq

aws route53 list-resource-record-sets --hosted-zone-id "${MyDnzHostedZoneId}" --query "ResourceRecordSets[?Type == 'A'].Name" | jq

aws route53 list-resource-record-sets --hosted-zone-id "${MyDnzHostedZoneId}" --query "ResourceRecordSets[?Type == 'A'].Name" --output text

# A 레코드 값 반복 조회

while true; do aws route53 list-resource-record-sets --hosted-zone-id "${MyDnzHostedZoneId}" --query "ResourceRecordSets[?Type == 'A']" | jq ; date ; echo ; sleep 1; done

- ExternalDNS 설치하기

#

MyDomain=<자신의 도메인>

# 자신의 Route 53 도메인 ID 조회 및 변수 지정

MyDnzHostedZoneId=$(aws route53 list-hosted-zones-by-name --dns-name "${MyDomain}." --query "HostedZones[0].Id" --output text)

# 변수 확인

echo $MyDomain, $MyDnzHostedZoneId

# ExternalDNS 배포

curl -s -O https://raw.githubusercontent.com/gasida/PKOS/main/aews/externaldns.yaml

MyDomain=$MyDomain MyDnzHostedZoneId=$MyDnzHostedZoneId envsubst < externaldns.yaml | kubectl apply -f -

- Service (NLB) + 도메인 연동 (ExternalDNS)

# 테스트 디플로이먼트 배포

cat <<EOF | kubectl apply -f -

apiVersion: apps/v1

kind: Deployment

metadata:

name: tetris

labels:

app: tetris

spec:

replicas: 1

selector:

matchLabels:

app: tetris

template:

metadata:

labels:

app: tetris

spec:

containers:

- name: tetris

image: bsord/tetris

---

apiVersion: v1

kind: Service

metadata:

name: tetris

annotations:

service.beta.kubernetes.io/aws-load-balancer-nlb-target-type: ip

service.beta.kubernetes.io/aws-load-balancer-scheme: internet-facing

service.beta.kubernetes.io/aws-load-balancer-cross-zone-load-balancing-enabled: "true"

service.beta.kubernetes.io/aws-load-balancer-backend-protocol: "http"

#service.beta.kubernetes.io/aws-load-balancer-healthcheck-port: "80"

spec:

selector:

app: tetris

ports:

- port: 80

protocol: TCP

targetPort: 80

type: LoadBalancer

loadBalancerClass: service.k8s.aws/nlb

EOF

* 배포 확인

* NLB에 ExternanDNS 로 도메인 연결

kubectl annotate service tetris "external-dns.alpha.kubernetes.io/hostname=tetris.$MyDomain"

while true; do aws route53 list-resource-record-sets --hosted-zone-id "${MyDnzHostedZoneId}" --query "ResourceRecordSets[?Type == 'A']" | jq ; date ; echo ; sleep 1; done

# 확인

dig +short tetris.$MyDomain @8.8.8.8

dig +short tetris.$MyDomain

9. CoreDNS

- DNS 쿼리 Flow

10. Topology Aware Routing

Topology Aware Hint 기능을 적용하지 않는다면 kube-proxy가 설정한 iptables 규칙은 임의의 Server Pod로 패킷을 전송하여 Cross-AZ 통신이 발생하게 됩니다. Topology Aware Hint 기능을 사용한다면 kube-proxy에 의해 iptables 규칙이 자신과 동일한 AZ에 위치하고 있는 Pod에게만 패킷을 전송하도록 설정하기 때문에 Cross-AZ 통신이 발생하지 않습니다. Pod 고가용성 구성이 필요하다.

즉, AZ을 넘어서 통신하는 트래픽 패턴을 없에서 같은 AZ내로만 트래픽을 보내준다. (AZ간에도 트래픽 비용이 발생하기 때문에 비용 절감을 위해)

ex) AZ A에 있는 client Pod는 AZ A에 있는 server Pod로만 접근하게 설정한다.

[실습]

- 현재 노드 AZ 배포 확인

kubectl get node --label-columns=topology.kubernetes.io/zone

NNAME STATUS ROLES AGE VERSION ZONE

ip-192-168-1-98.ap-northeast-2.compute.internal Ready <none> 24h v1.31.4-eks-aeac579 ap-northeast-2a

ip-192-168-2-213.ap-northeast-2.compute.internal Ready <none> 24h v1.31.4-eks-aeac579 ap-northeast-2b

ip-192-168-3-157.ap-northeast-2.compute.internal Ready <none> 24h v1.31.4-eks-aeac579 ap-northeast-2c

- 테스트를 위한 디플로이먼트와 서비스 배포

cat <<EOF | kubectl apply -f -

apiVersion: apps/v1

kind: Deployment

metadata:

name: deploy-echo

spec:

replicas: 3

selector:

matchLabels:

app: deploy-websrv

template:

metadata:

labels:

app: deploy-websrv

spec:

terminationGracePeriodSeconds: 0

containers:

- name: websrv

image: registry.k8s.io/echoserver:1.5

ports:

- containerPort: 8080

---

apiVersion: v1

kind: Service

metadata:

name: svc-clusterip

spec:

ports:

- name: svc-webport

port: 80

targetPort: 8080

selector:

app: deploy-websrv

type: ClusterIP

EOF

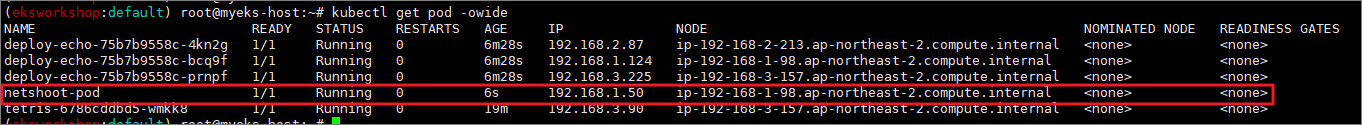

- 접속 테스트를 수행할 클라이언트 파드 배포

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: netshoot-pod

spec:

containers:

- name: netshoot-pod

image: nicolaka/netshoot

command: ["tail"]

args: ["-f", "/dev/null"]

terminationGracePeriodSeconds: 0

EOF

- 확인

접속 테스트를 할 netshoot-pod는 AZ1에 위치한 노드에 위치한다. 다른 AZ에 위치한 deploy-eco pod로 접근하면 AZ 트래픽 요금이 발생한다.

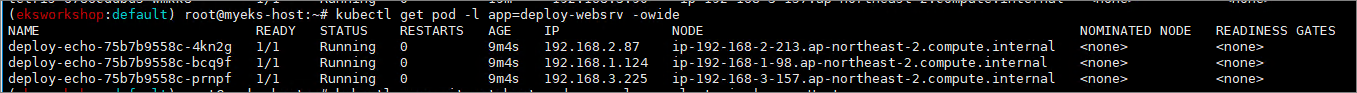

- 디플로이먼트 파드가 배포된 AZ(zone) 확인

kubectl get pod -l app=deploy-websrv -owide

# 테스트 파드(netshoot-pod)에서 ClusterIP 접속 시 부하분산 확인

> iptables의 부하분산 규칙 의해서 AZ 상관없이 랜덤으로 접속하게 된다.

kubectl exec -it netshoot-pod -- curl svc-clusterip | grep Hostname

Hostname: deploy-echo-7f67d598dc-h9vst

kubectl exec -it netshoot-pod -- curl svc-clusterip | grep Hostname

Hostname: deploy-echo-7f67d598dc-45trg

### iptables 확인

sep (endpoint) 파드 3개 확인 > 즉 3개의 파드로 랜덤 확률에 따라 부하분산된다.

[Topology Mode (=Aware Hint)]

설정 후 테스트 pod에서 cluster IP 접속 확인 : 같은 AZ의 목적지 파드로만 접근

- Topology Aware Routing 설정 : 서비스에 annotate에 아래처럼 추가

kubectl annotate service svc-clusterip "service.kubernetes.io/topology-mode=auto"

# endpointslices 확인 시, 기존에 없던 hints 가 추가되어 있음 >> 참고로 describe로는 hints 정보가 출력되지 않음

# kubectl get endpointslices -l kubernetes.io/service-name=svc-clusterip -o yaml

apiVersion: v1

items:

- addressType: IPv4

apiVersion: discovery.k8s.io/v1

endpoints:

- addresses:

- 192.168.2.87

conditions:

ready: true

serving: true

terminating: false

hints:

forZones:

- name: ap-northeast-2b

nodeName: ip-192-168-2-213.ap-northeast-2.compute.internal

targetRef:

kind: Pod

name: deploy-echo-75b7b9558c-4kn2g

namespace: default

uid: c897e326-b8c6-43e5-a194-44fda0eb3d15

zone: ap-northeast-2b

- addresses:

- 192.168.1.124

conditions:

ready: true

serving: true

terminating: false

hints:

forZones:

- name: ap-northeast-2a

nodeName: ip-192-168-1-98.ap-northeast-2.compute.internal

targetRef:

kind: Pod

name: deploy-echo-75b7b9558c-bcq9f

namespace: default

uid: fb4f3e7e-8e30-4b2a-b026-f21997d76467

zone: ap-northeast-2a

- addresses:

- 192.168.3.225

conditions:

ready: true

serving: true

terminating: false

hints:

forZones:

- name: ap-northeast-2c

nodeName: ip-192-168-3-157.ap-northeast-2.compute.internal

targetRef:

kind: Pod

name: deploy-echo-75b7b9558c-prnpf

namespace: default

uid: 6a450650-a920-4c3c-a22a-cae50fbe86be

zone: ap-northeast-2c

kind: EndpointSlice

metadata:

creationTimestamp: "2025-02-14T04:50:24Z"

generateName: svc-clusterip-

generation: 5

labels:

endpointslice.kubernetes.io/managed-by: endpointslice-controller.k8s.io

kubernetes.io/service-name: svc-clusterip

name: svc-clusterip-wn5f8

namespace: default

ownerReferences:

- apiVersion: v1

blockOwnerDeletion: true

controller: true

kind: Service

name: svc-clusterip

uid: 6173032b-8cae-440f-bc54-b8f3dc5f6123

resourceVersion: "306832"

uid: c8ae59b6-e282-47c3-9c39-a425eb6d781d

ports:

- name: svc-webport

port: 8080

protocol: TCP

kind: List

metadata:

resourceVersion: ""

# 100번 반복 접속 : 테스트 파드(netshoot-pod)와 같은 AZ(zone)의 목적지 파드로만 접속

kubectl exec -it netshoot-pod -- zsh -c "for i in {1..100}; do curl -s svc-clusterip | grep Hostname; done | sort | uniq -c | sort -nr"

100 Hostname: deploy-echo-75b7b9558c-bcq9f

### 노드 별 Iptables 정책 확인

sep (endpoint) 파드 1개 확인 (해당 노드와 같은 AZ에 배포된 파드만 출력) : 동인 AZ 간에서만 접

11. Amazon EKS now supports Amazon Application Recovery Controller

'Cloud > Kubernetes' 카테고리의 다른 글

| [AEWS3기] 4주차 EKS Observability (0) | 2025.02.27 |

|---|---|

| [AEWS3기] 3주차 EKS Storage, Managed Node Groups (0) | 2025.02.19 |

| [AEWS3기] 2주차 - EKS Networking (1) (0) | 2025.02.13 |

| [AEWS3기] 1주차 - Amazon EKS 설치 및 기본 사용 (4) (0) | 2025.02.08 |

| [AEWS3기] 1주차 - Amazon EKS 설치 및 기본 사용 (3) (0) | 2025.02.05 |