고정 헤더 영역

상세 컨텐츠

본문

0. 실습 환경

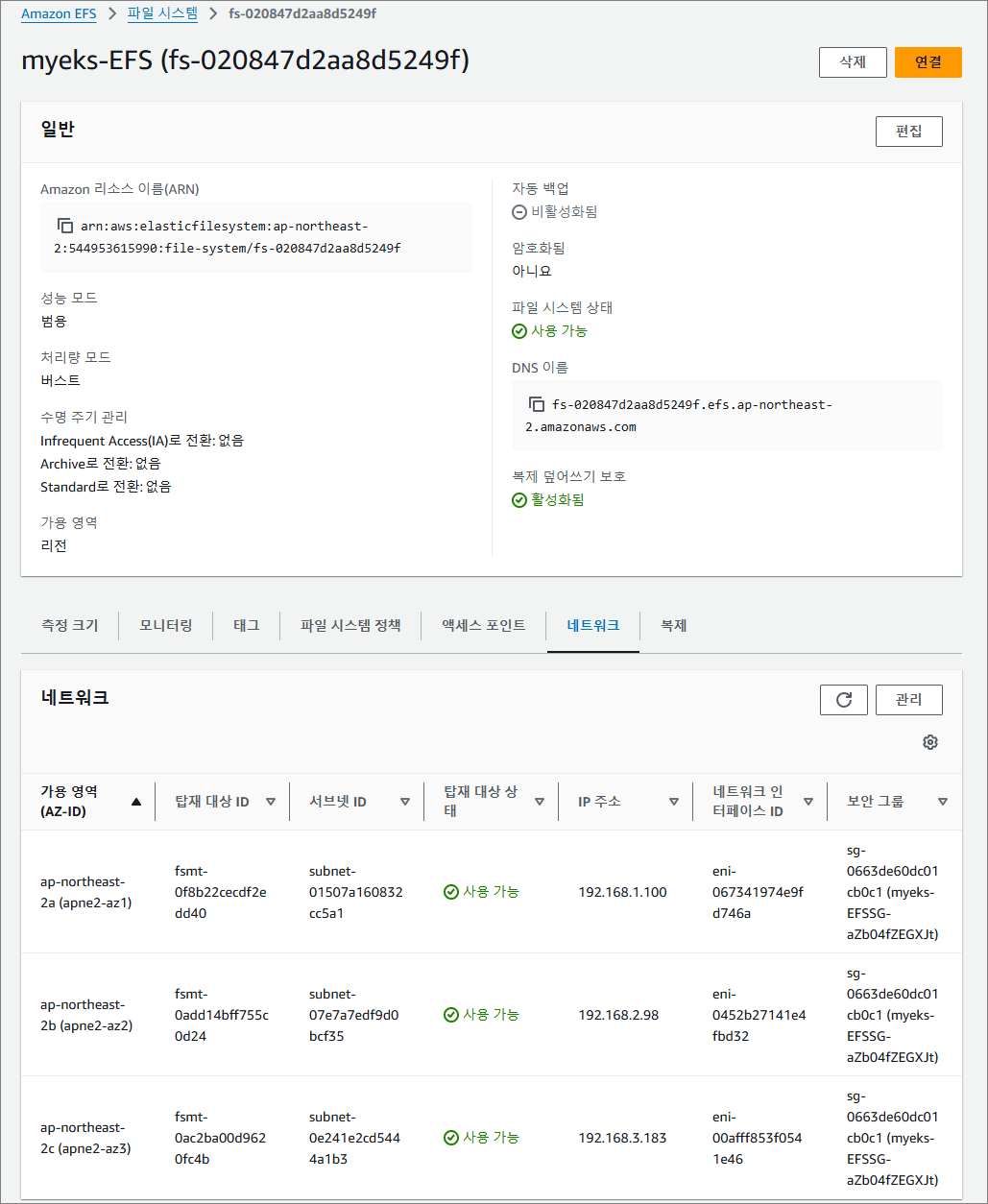

- myeks-vpc에 3곳의 AZ를 사용하는 Public / Private Subnet을 구성합니다. 로드밸런서 배포를 위한 Public / Private Subnet에 Tag 설정하였습니다. EFS 스토리지를 3개의 퍼블릭 서브넷에 ENI 네트워크 인터페이스로 연동하였습니다.

- operate-vpc에는 AZ1을 사용하는 Public / Private Subnet 구성합니다.

- VPC 간 내부 통신을 위한 VPC Peering을 구성합니다.

[vpc 구성] - Cloudformation 사용

# 배포

aws cloudformation deploy --template-file ~/myeks-3week.yaml \

--stack-name myeks --parameter-overrides KeyName=imcr SgIngressSshCidr=$(curl -s ipinfo.io/ip)/32 --region ap-northeast-2

# CloudFormation 스택 배포 완료 후 운영서버 EC2 IP 출력

aws cloudformation describe-stacks --stack-name myeks --query 'Stacks[*].Outputs[*].OutputValue' --output text

# 운영서버 EC2 에 SSH 접속

ssh -i <ssh 키파일> ec2-user@$(aws cloudformation describe-stacks --stack-name myeks --query 'Stacks[*].Outputs[0].OutputValue' --output text)

[myeks-vpc 구성] - eksctl 사용

- 배포할 yaml 파일 작성 및 환경변수 지정

export CLUSTER_NAME=myeks

# myeks-VPC/Subnet 정보 확인 및 변수 지정

export VPCID=$(aws ec2 describe-vpcs --filters "Name=tag:Name,Values=$CLUSTER_NAME-VPC" --query 'Vpcs[*].VpcId' --output text)

echo $VPCID

export PubSubnet1=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet1" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet2=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet2" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet3=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet3" --query "Subnets[0].[SubnetId]" --output text)

echo $PubSubnet1 $PubSubnet2 $PubSubnet3

#------------------

SSHKEYNAME=<각자 자신의 SSH Keypair 이름>

SSHKEYNAME=kp-gasida

- yaml 파일 작성

cat << EOF > myeks.yaml

apiVersion: eksctl.io/v1alpha5

kind: ClusterConfig

metadata:

name: myeks

region: ap-northeast-2

version: "1.31"

iam:

withOIDC: true # enables the IAM OIDC provider as well as IRSA for the Amazon CNI plugin

serviceAccounts: # service accounts to create in the cluster. See IAM Service Accounts

- metadata:

name: aws-load-balancer-controller

namespace: kube-system

wellKnownPolicies:

awsLoadBalancerController: true

vpc:

cidr: 192.168.0.0/16

clusterEndpoints:

privateAccess: true # if you only want to allow private access to the cluster

publicAccess: true # if you want to allow public access to the cluster

id: $VPCID

subnets:

public:

ap-northeast-2a:

az: ap-northeast-2a

cidr: 192.168.1.0/24

id: $PubSubnet1

ap-northeast-2b:

az: ap-northeast-2b

cidr: 192.168.2.0/24

id: $PubSubnet2

ap-northeast-2c:

az: ap-northeast-2c

cidr: 192.168.3.0/24

id: $PubSubnet3

addons:

- name: vpc-cni # no version is specified so it deploys the default version

version: latest # auto discovers the latest available

attachPolicyARNs: # attach IAM policies to the add-on's service account

- arn:aws:iam::aws:policy/AmazonEKS_CNI_Policy

configurationValues: |-

enableNetworkPolicy: "true"

- name: kube-proxy

version: latest

- name: coredns

version: latest

- name: metrics-server

version: latest

managedNodeGroups:

- amiFamily: AmazonLinux2023

desiredCapacity: 3

iam:

withAddonPolicies:

certManager: true # Enable cert-manager

externalDNS: true # Enable ExternalDNS

instanceType: t3.medium

preBootstrapCommands:

# install additional packages

- "dnf install nvme-cli links tree tcpdump sysstat ipvsadm ipset bind-utils htop -y"

labels:

alpha.eksctl.io/cluster-name: myeks

alpha.eksctl.io/nodegroup-name: ng1

maxPodsPerNode: 100

maxSize: 3

minSize: 3

name: ng1

ssh:

allow: true

publicKeyName: $SSHKEYNAME

tags:

alpha.eksctl.io/nodegroup-name: ng1

alpha.eksctl.io/nodegroup-type: managed

volumeIOPS: 3000

volumeSize: 120

volumeThroughput: 125

volumeType: gp3

EOF

# yaml로 eks 배포

# kubeconfig 파일 경로 위치 지정 :

export KUBECONFIG=$HOME/kubeconfig

혹은 각자 편한 경로 위치에 파일 지정

export KUBECONFIG=~/kubeconfig

# 배포

eksctl create cluster -f myeks.yaml --verbose 4

[운영서버 EC2 - EFS 마운트 테스트]

# EFS 마운트 대상 정보 확인

aws efs describe-mount-targets --file-system-id $(aws efs describe-file-systems --query "FileSystems[*].FileSystemId" --output text) | jq

{

"MountTargets": [

{

"OwnerId": "544953615990",

"MountTargetId": "fsmt-0f8b22cecdf2edd40",

"FileSystemId": "fs-020847d2aa8d5249f",

"SubnetId": "subnet-01507a160832cc5a1",

"LifeCycleState": "available",

"IpAddress": "192.168.1.100",

"NetworkInterfaceId": "eni-067341974e9fd746a",

"AvailabilityZoneId": "apne2-az1",

"AvailabilityZoneName": "ap-northeast-2a",

"VpcId": "vpc-0064df9685036aee6"

},

{

"OwnerId": "544953615990",

"MountTargetId": "fsmt-0add14bff755c0d24",

"FileSystemId": "fs-020847d2aa8d5249f",

"SubnetId": "subnet-07e7a7edf9d0bcf35",

"LifeCycleState": "available",

"IpAddress": "192.168.2.98",

"NetworkInterfaceId": "eni-0452b27141e4fbd32",

"AvailabilityZoneId": "apne2-az2",

"AvailabilityZoneName": "ap-northeast-2b",

"VpcId": "vpc-0064df9685036aee6"

},

{

"OwnerId": "544953615990",

"MountTargetId": "fsmt-0ac2ba00d9620fc4b",

"FileSystemId": "fs-020847d2aa8d5249f",

"SubnetId": "subnet-0e241e2cd5444a1b3",

"LifeCycleState": "available",

"IpAddress": "192.168.3.183",

"NetworkInterfaceId": "eni-00afff853f0541e46",

"AvailabilityZoneId": "apne2-az3",

"AvailabilityZoneName": "ap-northeast-2c",

"VpcId": "vpc-0064df9685036aee6"

}

}

# IP만 출력 :

aws efs describe-mount-targets --file-system-id $(aws efs describe-file-systems --query "FileSystems[*].FileSystemId" --output text) --query "MountTargets[*].IpAddress" --output text

192.168.1.100 192.168.2.98 192.168.3.183

# EFS 도메인 이름(예시) : fs-040469b8fab273469.efs.ap-northeast-2.amazonaws.com

dig +short $(aws efs describe-file-systems --query "FileSystems[*].FileSystemId" --output text).efs.ap-northeast-2.amazonaws.com

# EFS 마운트 테스트

EFSIP1=<IP만 출력에서 아무 IP나 지정>

EFSIP1=192.168.1.71

df -hT

mkdir /mnt/myefs

mount -t nfs4 -o nfsvers=4.1,rsize=1048576,wsize=1048576,hard,timeo=600,retrans=2,noresvport $EFSIP1:/ /mnt/myefs

findmnt -t nfs4

df -hT --type nfs4

# 파일 작성

nfsstat

echo "EKS Workshop" > /mnt/myefs/memo.txt

nfsstat

ls -l /mnt/myefs

cat /mnt/myefs/memo.txt

# EC2 재부팅 이후에도 mount 탑재가 될 수 있게 설정 해보자! : (힌트 : /etc/fstab)

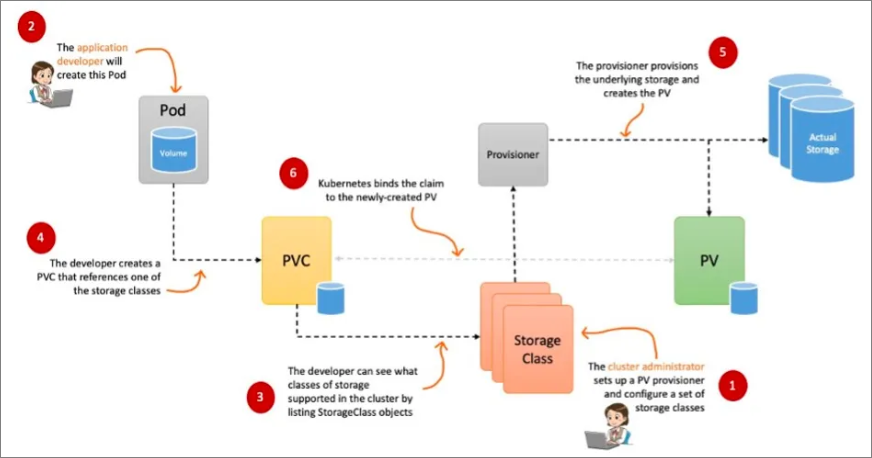

1. 스토리지의 이해

Pod의 내부 데이터(컨테이너)는 Pod가 삭제되면서 함께 삭제된다.

- Database (pod) 처럼 데이터 보존이 필요 > 상태가 있는 (stateful) 어플리케이션 : PV, PVC가 등장

로컬 볼륨 (hostPath) > Persistent Volume, PV로 연결해 어느 노드에서도 연결하여 사용할 수 있다.

(ex) NFS, AWS EBS , Ceph등

- 동적 프로비저닝 (Dynamic Provisioning) : Pod가 생성될 때 자동으로 볼륨을 마운트하여 파드에 연결하는 기능

- Reclaim Policy : PV의 사용이 끝났을 때 해당 볼륨을 어떻게 초기화 할 것인지 설정, Retain (보존), Delete (삭제, EBS 볼륨도 함께 삭제) 방식이 있다.

[스토리지 소개]

출처 : http://https://kubetm.github.io/k8s/03-beginner-basic-resource/volume/

- 볼륨 : emptyDir, hostPaht, PV/PVC

- 다양한 볼륨 사용 가능 : K8S 자체 제공 (hostPath local), 온프레미스 솔루션 (ceph 등), NFS, 클라우드 스토리지 (AWS EBS 등)

- 동적 프로비저닝 & 볼륨 상태, ReclaimPolicy

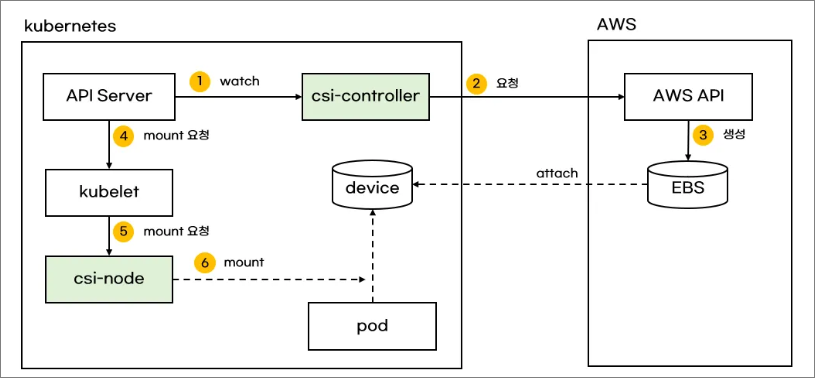

[CSI (Container Storage Ingerfate)]

- CSI 를 사용하면, K8S 의 공통화된 CSI 인터페이스를 통해 다양한 프로바이더를 사용할 수 있다.

- CSI Driver 배경 : Kubernetes source code 내부에 존재하는 AWS EBS provisioner는 당연히 Kubernetes release lifecycle을 따라서 배포되므로, provisioner 신규 기능을 사용하기 위해서는 Kubernetes version을 업그레이드해야 하는 제약 사항이 있습니다. 따라서, Kubernetes 개발자는 Kubernetes 내부에 내장된 provisioner (in-tree)를 모두 삭제하고, 별도의 controller Pod을 통해 동적 provisioning을 사용할 수 있도록 만들었습니다. 이것이 바로 CSI (Container Storage Interface) driver 입니다

- CSI driver 구조

AWS EBS CSI dreiver의 구조도 아래와 같다. 오른쪽의 Stateful Set 또는 Deployment로 배포된 contoller Pod가 AWS API를 사용해 실제 EBS 볼륨을 생성하는 역할을 한다. 왼족의 Daemon Set으로 배포된 node pod는 AWS API를 사용해 쿠버네티스 node (EC2 instance)에 EBS 볼륨을 attach 한다.

[실습 - 파드 기본 및 empty 저장소 동작 확인]

- pod 기본 저장소 (pod가 재기동되거나 삭제되면 데이터도 함께 삭제된다.)

# redis 파드 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: redis

spec:

terminationGracePeriodSeconds: 0

containers:

- name: redis

image: redis

EOF

# redis 파드 내에 파일 작성

kubectl exec -it redis -- pwd

kubectl exec -it redis -- sh -c "echo hello > /data/hello.txt"

kubectl exec -it redis -- cat /data/hello.txt

# ps 설치

kubectl exec -it redis -- sh -c "apt update && apt install procps -y"

kubectl exec -it redis -- ps aux

# redis 프로세스 강제 종료 : 파드가 어떻게 되나요? hint) restartPolicy

kubectl exec -it redis -- kill 1

kubectl get pod

# redis 파드 내에 파일 확인

kubectl exec -it redis -- cat /data/hello.txt

kubectl exec -it redis -- ls -l /data

# 파드 삭제

kubectl delete pod redis

pod가 재기동되니 저장된 데이터도 함께 삭제되었다

.

- empty 저장소 확인 (pod가 재기동되어도 내부 데이터는 살아있지만 pod가 삭제 후 재생성되면 데이터는 삭제된다.)

# redis 파드 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: redis

spec:

terminationGracePeriodSeconds: 0

containers:

- name: redis

image: redis

volumeMounts:

- name: redis-storage

mountPath: /data/redis

volumes:

- name: redis-storage

emptyDir: {}

EOF

# redis 파드 내에 파일 작성

kubectl exec -it redis -- pwd

kubectl exec -it redis -- sh -c "echo hello > /data/redis/hello.txt"

kubectl exec -it redis -- cat /data/redis/hello.txt

pod가 재기동되어도 데이터는 삭제되지 않는다.

# ps 설치

kubectl exec -it redis -- sh -c "apt update && apt install procps -y"

kubectl exec -it redis -- ps aux

# redis 프로세스 강제 종료 : 파드가 어떻게 되나요? hint) restartPolicy

kubectl exec -it redis -- kill 1

kubectl get pod

# redis 파드 내에 파일 확인

kubectl exec -it redis -- cat /data/redis/hello.txt

kubectl exec -it redis -- ls -l /data/redis

pod를 완전히 삭제 후 재기동하면 데이터는 삭제된다.

kubectl delete pod redis

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: redis

spec:

terminationGracePeriodSeconds: 0

containers:

- name: redis

image: redis

volumeMounts:

- name: redis-storage

mountPath: /data/redis

volumes:

- name: redis-storage

emptyDir: {}

EOF

# redis 파드 내에 파일 확인

kubectl exec -it redis -- cat /data/redis/hello.txt

kubectl exec -it redis -- ls -l /data/redis

[실습 - 호스트 Path를 사용하는 PV/PVC : local-path-provisioner 스토리지 클래스 배포]

- local-path-provisioner 스토리지 클래스 설치하기

# 배포

# local-path-provisioner 설치

kubectl apply -f https://raw.githubusercontent.com/rancher/local-path-provisioner/v0.0.31/deploy/local-path-storage.yaml

...

apiVersion: storage.k8s.io/v1

kind: StorageClass

metadata:

name: local-path

provisioner: rancher.io/local-path

volumeBindingMode: WaitForFirstConsumer

reclaimPolicy: Delete

---

apiVersion: v1

kind: ConfigMap

metadata:

name: local-path-config

namespace: local-path-storage

data:

config.json: |-

{

"nodePathMap":[

{

"node":"DEFAULT_PATH_FOR_NON_LISTED_NODES",

"paths":["/opt/local-path-provisioner"] # 각 노드의 호스트 path의 저장소를 사용

}

]

}

setup: |-

#!/bin/sh

set -eu

mkdir -m 0777 -p "$VOL_DIR"

teardown: |-

#!/bin/sh

set -eu

rm -rf "$VOL_DIR"

...

# 확인

kubectl get-all -n local-path-storage

kubectl get pod -n local-path-storage -owide

kubectl describe cm -n local-path-storage local-path-config

kubectl get sc

kubectl get sc local-path

NAME PROVISIONER RECLAIMPOLICY VOLUMEBINDINGMODE ALLOWVOLUMEEXPANSION AGE

local-path rancher.io/local-path Delete WaitForFirstConsumer false 34s

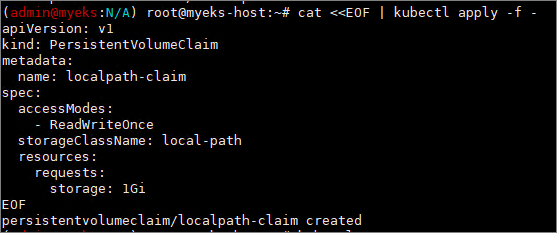

- PV/PVC 사용 Pod 생성

# PVC 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: localpath-claim

spec:

accessModes:

- ReadWriteOnce

storageClassName: local-path

resources:

requests:

storage: 1Gi

EOF

# PVC 확인

kubectl get pvc

kubectl describe pvc

- pod 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: app

spec:

terminationGracePeriodSeconds: 3

containers:

- name: app

image: centos

command: ["/bin/sh"]

args: ["-c", "while true; do echo \$(date -u) >> /data/out.txt; sleep 5; done"]

volumeMounts:

- name: persistent-storage

mountPath: /data

volumes:

- name: persistent-storage

persistentVolumeClaim:

claimName: localpath-claim

EOF

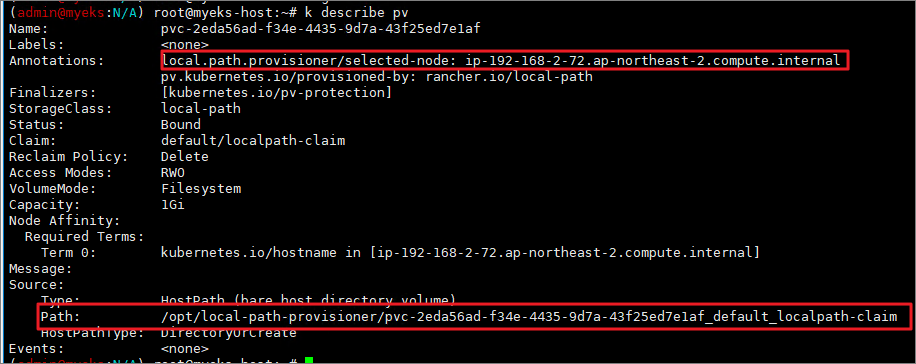

# 파드 확인

kubectl get pod,pv,pvc

kubectl describe pv # Node Affinity 확인

kubectl exec -it app -- tail -f /data/out.txt

# 워커노드 중 현재 파드가 배포되어 있다면, 아래 경로에 out.txt 파일 존재 확인

for node in $N1 $N2 $N3; do ssh ec2-user@$node tree /opt/local-path-provisioner; done

- 실제 노드 접속해서 확인

[pod 삭제 및 재생성 : 데이터 유지 여부 확인]

- 파드 삭제 후 PV/PVC 확인

# 파드 삭제 후 PV/PVC 확인

kubectl delete pod app

kubectl get pod,pv,pvc

for node in $N1 $N2 $N3; do ssh ec2-user@$node tree /opt/local-path-provisioner; done

- pod를 삭제해도 노드 동적 스토리지에는 out.txt 파일이 남아있다.

실제 노드 접속해서 확인!

- 파드 재생성 및 데이터 확인

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: app

spec:

terminationGracePeriodSeconds: 3

containers:

- name: app

image: centos

command: ["/bin/sh"]

args: ["-c", "while true; do echo \$(date -u) >> /data/out.txt; sleep 5; done"]

volumeMounts:

- name: persistent-storage

mountPath: /data

volumes:

- name: persistent-storage

persistentVolumeClaim:

claimName: localpath-claim

EOF

# 확인

kubectl exec -it app -- head /data/out.txt

kubectl exec -it app -- tail -f /data/out.txt

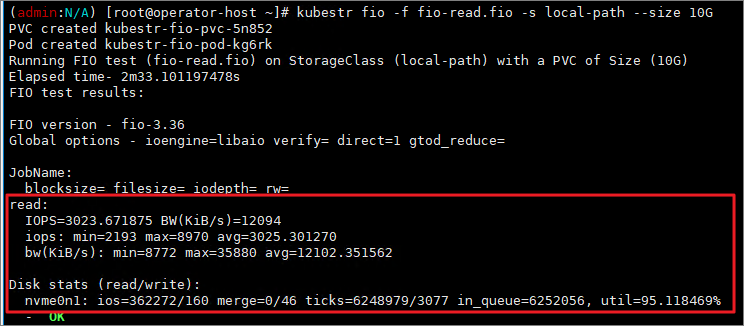

[kubestr 모니터링 및 성능 측정 확인]

- kubestr tool을 이용한 성능 측정하기 : local-path와 NFS 등 스토리지 클래스의 IOPS 차이 확인

# [운영서버 EC2] kubestr 툴 다운로드 - Link

wget https://github.com/kastenhq/kubestr/releases/download/v0.4.48/kubestr_0.4.48_Linux_amd64.tar.gz

tar xvfz kubestr_0.4.48_Linux_amd64.tar.gz && mv kubestr /usr/local/bin/ && chmod +x /usr/local/bin/kubestr

# 스토리지클래스 점검

kubestr -h

kubestr

각 워커 노드에 아래와 같이 iostat 명령 실행 : 입출력 통계 확인을 위해서

iostat -xmdz 1

--------------------------------------------------------------

# rrqm/s : 초당 드라이버 요청 대기열에 들어가 병합된 읽기 요청 횟수

# wrqm/s : 초당 드라이버 요청 대기열에 들어가 병합된 쓰기 요청 횟수

# r/s : 초당 디스크 장치에 요청한 읽기 요청 횟수

# w/s : 초당 디스크 장치에 요청한 쓰기 요청 횟수

# rMB/s : 초당 디스크 장치에서 읽은 메가바이트 수

# wMB/s : 초당 디스크 장치에 쓴 메가바이트 수

# await : 가장 중요한 지표, 평균 응답 시간. 드라이버 요청 대기열에서 기다린 시간과 장치의 I/O 응답시간을 모두 포함 (단위: ms)

iostat -xmdz 1 -p xvdf

Device: rrqm/s wrqm/s r/s w/s rMB/s wMB/s avgrq-sz avgqu-sz await r_await w_await svctm %util

xvdf 0.00 0.00 2637.93 0.00 10.30 0.00 8.00 6.01 2.28 2.28 0.00 0.33 86.21

--------------------------------------------------------------

[랜덤 읽기 성능 테스트 수행 (3분정도 소요)]

: libaio 엔진과 다이렉트 I/O를 사용하여 고성능 스토리지의 랜덤 읽기 성능을 측정

: direct=1 옵션을 통해 OS 캐시를 사용하지 않고 직접 디스크 I/O 수행

cat << EOF > fio-read.fio

[global]

ioengine=libaio

direct=1

bs=4k

runtime=120

time_based=1

iodepth=16

numjobs=4

group_reporting

size=1g

rw=randread

[read]

EOF

kubestr fio -f fio-read.fio -s local-path --size 10G

읽기 성능을 위한 더미 파일을 만들기 때문에 초반에는 w/s가 커지다가 읽기가 수행되면 r/s가 커지는 것을 알 수 있음.

- 결과 (참고 : [NVMe] Read 평균 IOPS는 20300이다.) 노드 스토리지랑 동일한 I/O가 나옴

[랜덤 쓰기 성능 테스트 수행 (5분 정도 수행)]

# numjobs=16, iodepth=16 : 총 16×16 = 256개의 I/O 요청이 동시에 발생

**cat << EOF > fio-write.fio**

[global]

ioengine=libaio

numjobs=16

iodepth=16

direct=1

bs=4k

runtime=120

time_based=1

size=1g

group_reporting

**rw=randrw

rwmixread=0

rwmixwrite=100**

**[write]

EOF

kubestr fio -f fio-write.fio -s local-path --size 20G**

2. AWS EBS Controller

- volume (ebs-csi-controller) : EBS CSI Driver 동작, 파드에 ebs가 필요할 경우 ebs 볼륨을 pod에 attach한다. 동일 AZ에 있는 EC2 인스턴스안 Pod에 스토리지를 연결한다.

# AWS CSI 드라이버 구성 요소 :

1. CSI-controller : AWS API 호출로 AWS 스토리지 관리

2. CSI-Node : kubelet과 상호작용하면서 AWS 스토리지를 pod에 마운트

[실습]

- 설치 : Amazon EBS CSI Driver as an Amazon EKS add on

# 아래는 aws-ebs-csi-driver 전체 버전 정보와 기본 설치 버전(True) 정보 확인

aws eks describe-addon-versions \

--addon-name aws-ebs-csi-driver \

--kubernetes-version 1.31 \

--query "addons[].addonVersions[].[addonVersion, compatibilities[].defaultVersion]" \

--output text

# ISRA 설정 : AWS관리형 정책 AmazonEBSCSIDriverPolicy 사용

eksctl create iamserviceaccount \

--name ebs-csi-controller-sa \

--namespace kube-system \

--cluster ${CLUSTER_NAME} \

--attach-policy-arn arn:aws:iam::aws:policy/service-role/AmazonEBSCSIDriverPolicy \

--approve \

--role-only \

--role-name AmazonEKS_EBS_CSI_DriverRole

# ISRA 확인

eksctl get iamserviceaccount --cluster ${CLUSTER_NAME}

NAMESPACE NAME ROLE ARN

kube-system aws-load-balancer-controller arn:aws:iam::544953615990:role/eksctl-myeks-addon-iamserviceaccount-kube-sys-Role1-uB11v8FqrdQc

kube-system ebs-csi-controller-sa arn:aws:iam::544953615990:role/AmazonEKS_EBS_CSI_DriverRole

# Amazon EBS CSI driver addon 배포(설치)

export ACCOUNT_ID=$(aws sts get-caller-identity --query 'Account' --output text)

eksctl create addon --name aws-ebs-csi-driver --cluster ${CLUSTER_NAME} --service-account-role-arn arn:aws:iam::${ACCOUNT_ID}:role/AmazonEKS_EBS_CSI_DriverRole --force

kubectl get sa -n kube-system ebs-csi-controller-sa -o yaml | head -5

# 확인

eksctl get addon --cluster ${CLUSTER_NAME}

kubectl get deploy,ds -l=app.kubernetes.io/name=aws-ebs-csi-driver -n kube-system

kubectl get pod -n kube-system -l 'app in (ebs-csi-controller,ebs-csi-node)'

kubectl get pod -n kube-system -l app.kubernetes.io/component=csi-driver

- csinodes 확인

# csinodes 확인

kubectl api-resources | grep -i csi

kubectl get csinodes

kubectl describe csinodes

노드에 연결 가능한 EBS 최대 수량은 25개가 default이다.

# 노드에 연결 가능한 EBS 최대 수량 변경하기

aws eks update-addon --cluster-name ${CLUSTER_NAME} --addon-name aws-ebs-csi-driver \

--addon-version v1.39.0-eksbuild.1 --configuration-values '{

"node": {

"volumeAttachLimit": 31,

"enableMetrics": true

}

}'

혹은

cat << EOF > node-attachments.yaml

"node":

"volumeAttachLimit": 31

"enableMetrics": true

EOF

aws eks update-addon --cluster-name ${CLUSTER_NAME} --addon-name aws-ebs-csi-driver \

--addon-version v1.39.0-eksbuild.1 --configuration-values 'file://node-attachments.yaml'

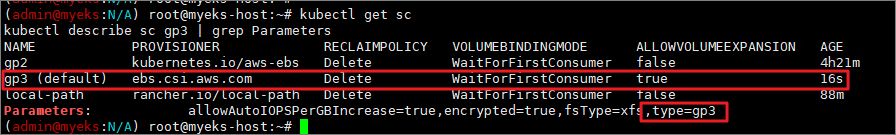

[gp3 스토리지 클래스 생성]

kubectl get sc

cat <<EOF | kubectl apply -f -

kind: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: gp3

annotations:

storageclass.kubernetes.io/is-default-class: "true"

allowVolumeExpansion: true

provisioner: ebs.csi.aws.com

volumeBindingMode: WaitForFirstConsumer

parameters:

type: gp3

allowAutoIOPSPerGBIncrease: 'true'

encrypted: 'true'

fsType: xfs # 기본값이 ext4

EOF

volumeBindingMode 섹션 : 볼륨 바인딩과 동적 프로비저닝의 시작 시기를 제어한다. Immediate 모드가 default.

- Immediate (기본값) : PVC가 생성되자마자 즉시 PV와 바인딩된다. 동적 프로비저닝(dynamic provisioning)이 아닌 사전 프로비저닝된 PV를 사용할 때 유용

단점 : 스케줄링 전에 바인딩되므로, 노드 리소스 및 토폴로지를 고려하지 못할 수 있음. 예를 들어 특정 가용 영역(AZ)에만 존재하는 PV에 바인딩되었는데, Pod가 다른 AZ로 스케줄링되면 문제가 발생할 수 있음.

- WaitForFirstConsumer : PVC가 생성되었을 때 즉시 바인딩하지 않고, 해당 PVC를 사용하는 Pod가 스케줄링될 때까지 대기한다, Pod가 어느 노드에서 실행될지 결정된 후, 해당 노드에 적합한 PV가 선택되어 바인딩된다.

토폴로지 제약 조건을 고려하는 스토리지(AWS EBS, GCE PD, Ceph 등)에 적합

장점: Pod의 스케줄링을 고려하여 적절한 AZ 또는 노드에서 바인딩되므로, 리소스 낭비와 불필요한 스케줄링 오류를 방지할 수 있음.

| Immediate | PVC 생성 즉시 바인딩 | 공용 PV 풀 사용, 특정 노드 의존성 없음 |

| WaitForFirstConsumer | PVC를 사용하는 Pod가 스케줄링된 후 바인딩 | 특정 AZ/노드에 맞춰야 하는 볼륨 (EBS, GCE PD 등) |

[PVC/PV pod 테스트]

# 워커노드의 EBS 볼륨 확인 : tag(키/값) 필터링 - 링크

aws ec2 describe-volumes --filters Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node --output table

aws ec2 describe-volumes --filters Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node --query "Volumes[*].Attachments" | jq

aws ec2 describe-volumes --filters Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node --query "Volumes[*].{ID:VolumeId,Tag:Tags}" | jq

aws ec2 describe-volumes --filters Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node --query "Volumes[].[VolumeId, VolumeType, Attachments[].[InstanceId, State][]][]" | jq

aws ec2 describe-volumes --filters Name=tag:Name,Values=$CLUSTER_NAME-ng1-Node --query "Volumes[].{VolumeId: VolumeId, VolumeType: VolumeType, InstanceId: Attachments[0].InstanceId, State: Attachments[0].State}" | jq

# 워커노드에서 파드에 추가한 EBS 볼륨 확인

aws ec2 describe-volumes --filters Name=tag:ebs.csi.aws.com/cluster,Values=true --output table

aws ec2 describe-volumes --filters Name=tag:ebs.csi.aws.com/cluster,Values=true --query "Volumes[*].{ID:VolumeId,Tag:Tags}" | jq

aws ec2 describe-volumes --filters Name=tag:ebs.csi.aws.com/cluster,Values=true --query "Volumes[].{VolumeId: VolumeId, VolumeType: VolumeType, InstanceId: Attachments[0].InstanceId, State: Attachments[0].State}" | jq

# 워커노드에서 파드에 추가한 EBS 볼륨 모니터링

while true; do aws ec2 describe-volumes --filters Name=tag:ebs.csi.aws.com/cluster,Values=true --query "Volumes[].{VolumeId: VolumeId, VolumeType: VolumeType, InstanceId: Attachments[0].InstanceId, State: Attachments[0].State}" --output text; date; sleep 1; done

모니터링 ... 추가된 ebs 볼륨만 모니터링한다.

# PVC 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: ebs-claim

spec:

accessModes:

- ReadWriteOnce

resources:

requests:

storage: 4Gi

storageClassName: gp3

EOF

kubectl get pvc,pv

# 파드 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: app

spec:

terminationGracePeriodSeconds: 3

containers:

- name: app

image: centos

command: ["/bin/sh"]

args: ["-c", "while true; do echo \$(date -u) >> /data/out.txt; sleep 5; done"]

volumeMounts:

- name: persistent-storage

mountPath: /data

volumes:

- name: persistent-storage

persistentVolumeClaim:

claimName: ebs-claim

EOF

# PVC, 파드 확인

kubectl get pvc,pv,pod

kubectl get VolumeAttachment

kubectl df-pv

# PV 상세 확인 : nodeAffinity 내용의 의미는?

>> AZ 레벨로 attach가 가능하기 때문에 노드 내의 pod가 재생성되어도 pv 사용이 가능

kubectl get pv -o yaml

...

nodeAffinity:

required:

nodeSelectorTerms:

- matchExpressions:

- key: topology.ebs.csi.aws.com/zone

operator: In

values:

- ap-northeast-2b

...

kubectl get node --label-columns=topology.ebs.csi.aws.com/zone,topology.k8s.aws/zone-id

kubectl describe node

# 파일 내용 추가 저장 확인

kubectl exec app -- tail -f /data/out.txt

## 파드 내에서 볼륨 정보 확인

kubectl exec -it app -- sh -c 'df -hT --type=overlay'

kubectl exec -it app -- sh -c 'df -hT --type=xfs'

- volume 용량 증설 (축소는 불가능하다.)

# 현재 pv 의 이름을 기준하여 4G > 10G 로 증가 : .spec.resources.requests.storage의 4Gi 를 10Gi로 변경

kubectl get pvc ebs-claim -o jsonpath={.spec.resources.requests.storage} ; echo

kubectl get pvc ebs-claim -o jsonpath={.status.capacity.storage} ; echo

kubectl patch pvc ebs-claim -p '{"spec":{"resources":{"requests":{"storage":"10Gi"}}}}'

# 확인 : 볼륨 용량 수정 반영이 되어야 되니, 수치 반영이 조금 느릴수 있다. (옵티마이징이 오래 걸림)

kubectl exec -it app -- sh -c 'df -hT --type=xfs'

kubectl df-pv

aws ec2 describe-volumes --volume-ids $(kubectl get pv -o jsonpath="{.items[0].spec.csi.volumeHandle}") | jq

3. AWS Volume SnapShots Controller

[volumesnapshot 컨트롤러 설치]

# Install Snapshot CRDs

kubectl apply -f https://raw.githubusercontent.com/kubernetes-csi/external-snapshotter/master/client/config/crd/snapshot.storage.k8s.io_volumesnapshots.yaml

kubectl apply -f https://raw.githubusercontent.com/kubernetes-csi/external-snapshotter/master/client/config/crd/snapshot.storage.k8s.io_volumesnapshotclasses.yaml

kubectl apply -f https://raw.githubusercontent.com/kubernetes-csi/external-snapshotter/master/client/config/crd/snapshot.storage.k8s.io_volumesnapshotcontents.yaml

kubectl get crd | grep snapshot

kubectl api-resources | grep snapshot

# Install Common Snapshot Controller

kubectl apply -f https://raw.githubusercontent.com/kubernetes-csi/external-snapshotter/master/deploy/kubernetes/snapshot-controller/rbac-snapshot-controller.yaml

kubectl apply -f https://raw.githubusercontent.com/kubernetes-csi/external-snapshotter/master/deploy/kubernetes/snapshot-controller/setup-snapshot-controller.yaml

kubectl get deploy -n kube-system snapshot-controller

kubectl get pod -n kube-system

# Install Snapshotclass

kubectl apply -f https://raw.githubusercontent.com/kubernetes-sigs/aws-ebs-csi-driver/master/examples/kubernetes/snapshot/manifests/classes/snapshotclass.yaml

kubectl get vsclass # 혹은 volumesnapshotclasses

kubectl describe vsclass

[테스트 PVC/pod 생성]

# PVC 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: ebs-claim

spec:

accessModes:

- ReadWriteOnce

resources:

requests:

storage: 4Gi

storageClassName: gp3

EOF

kubectl get pvc,pv

# 파드 생성

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: app

spec:

terminationGracePeriodSeconds: 3

containers:

- name: app

image: centos

command: ["/bin/sh"]

args: ["-c", "while true; do echo \$(date -u) >> /data/out.txt; sleep 5; done"]

volumeMounts:

- name: persistent-storage

mountPath: /data

volumes:

- name: persistent-storage

persistentVolumeClaim:

claimName: ebs-claim

EOF

- 파일 내용 추가 저장 확인

- 볼륩 스냅샷 생성

# VolumeSnapshot 생성 : Create a VolumeSnapshot referencing the PersistentVolumeClaim name

# AWS 관리 콘솔 EBS 스냅샷 확인

cat <<EOF | kubectl apply -f -

apiVersion: snapshot.storage.k8s.io/v1

kind: VolumeSnapshot

metadata:

name: ebs-volume-snapshot

spec:

volumeSnapshotClassName: csi-aws-vsc

source:

persistentVolumeClaimName: ebs-claim

EOF

# VolumeSnapshot 확인

kubectl get volumesnapshot

kubectl get volumesnapshot ebs-volume-snapshot -o jsonpath={.status.boundVolumeSnapshotContentName} ; echo

kubectl describe volumesnapshot.snapshot.storage.k8s.io ebs-volume-snapshot

kubectl get volumesnapshotcontents

# VolumeSnapshot ID 확인

kubectl get volumesnapshotcontents -o jsonpath='{.items[*].status.snapshotHandle}' ; echo

# AWS EBS 스냅샷 확인

aws ec2 describe-snapshots --owner-ids self | jq

aws ec2 describe-snapshots --owner-ids self --query 'Snapshots[]' --output table

- 볼륩 삭제하여 강제로 장애 상황 만들기

kubectl delete pod app && kubectl delete pvc ebs-claim

- 스냅샷으로 복원하기

# 스냅샷에서 PVC 로 복원

kubectl get pvc,pv

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: ebs-snapshot-restored-claim

spec:

storageClassName: gp3

accessModes:

- ReadWriteOnce

resources:

requests:

storage: 4Gi

dataSource:

name: ebs-volume-snapshot

kind: VolumeSnapshot

apiGroup: snapshot.storage.k8s.io

EOF

- 생성 확인

4. AWS EFS Controller

[EFS 파일시스템 확인 및 EFS Controller Addon 설치]

# EFS 정보 확인

aws efs describe-file-systems --query "FileSystems[*].FileSystemId" --output text

# 아래는 aws-efs-csi-driver 전체 버전 정보와 기본 설치 버전(True) 정보 확인

aws eks describe-addon-versions \

--addon-name aws-efs-csi-driver \

--kubernetes-version 1.31 \

--query "addons[].addonVersions[].[addonVersion, compatibilities[].defaultVersion]" \

--output text

# ISRA 설정 : 고객관리형 정책 AmazonEKS_EFS_CSI_Driver_Policy 사용

eksctl create iamserviceaccount \

--name efs-csi-controller-sa \

--namespace kube-system \

--cluster ${CLUSTER_NAME} \

--attach-policy-arn arn:aws:iam::aws:policy/service-role/AmazonEFSCSIDriverPolicy \

--approve \

--role-only \

--role-name AmazonEKS_EFS_CSI_DriverRole

- ISRA 확인

# Amazon EFS CSI driver addon 배포(설치)

export ACCOUNT_ID=$(aws sts get-caller-identity --query 'Account' --output text)

eksctl create addon --name aws-efs-csi-driver --cluster ${CLUSTER_NAME} --service-account-role-arn arn:aws:iam::${ACCOUNT_ID}:role/AmazonEKS_EFS_CSI_DriverRole --force

kubectl get sa -n kube-system efs-csi-controller-sa -o yaml | head -5

[EFS 파일시스템을 파드가 사용하게 설정]

# 실습 코드 clone

git clone https://github.com/kubernetes-sigs/aws-efs-csi-driver.git /root/efs-csi

cd /root/efs-csi/examples/kubernetes/multiple_pods/specs && tree

# EFS 스토리지클래스 생성 및 확인

cat storageclass.yaml

kubectl apply -f storageclass.yaml

kubectl get sc efs-sc

# PV 생성 및 확인 : volumeHandle을 자신의 EFS 파일시스템ID로 변경

EfsFsId=$(aws efs describe-file-systems --query "FileSystems[*].FileSystemId" --output text)

sed -i "s/fs-4af69aab/$EfsFsId/g" pv.yaml

cat pv.yaml

apiVersion: v1

kind: PersistentVolume

metadata:

name: efs-pv

spec:

capacity:

storage: 5Gi

volumeMode: Filesystem

accessModes:

- ReadWriteMany

persistentVolumeReclaimPolicy: Retain

storageClassName: efs-sc

csi:

driver: efs.csi.aws.com

volumeHandle: fs-020847d2aa8d5249f

kubectl apply -f pv.yaml

kubectl get pv; kubectl describe pv

# PVC 생성 및 확인

cat claim.yaml

kubectl apply -f claim.yaml

kubectl get pvc

cat pod1.yaml pod2.yaml

kubectl apply -f pod1.yaml,pod2.yaml

kubectl df-pv

운영 ec2 서버에도 해당 efs를 마운트시켜놓았기 때문에 pod와 함께 그 스토리지를 공유한다.

다 같은 파일을 호출한다.

[EFS 파일시스템을 여러 파드가 사용하게 설정] : Dynamic Provisioning using EFS

Access Point 경로를 추가 : EFS의 특정 부분을 격리하고 보안성을 높힐 수 있다.

cat storageclass.yaml

kind: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: efs-sc

provisioner: efs.csi.aws.com

parameters:

provisioningMode: efs-ap

fileSystemId: fs-020847d2aa8d5249f

directoryPerms: "700"

gidRangeStart: "1000" # optional

gidRangeEnd: "2000" # optional

basePath: "/dynamic_provisioning" # optional

subPathPattern: "${.PVC.namespace}/${.PVC.name}" # optional

ensureUniqueDirectory: "true" # optional

reuseAccessPoint: "false"

5. EKS Persistent Volumes for Instance Store & Add NodeGroup

EC2 인스턴스 스토어 (임시블록 스토리지)

EC2 인스턴스에 임시 블록 스토리지를 제공한다. 이 스토리지는 호스트 컴퓨터에 물리적으로 연결된 디스크에서 제공한다. EBS와 달리 인스턴스를 종료하거나 중지하면 데이터도 함께 삭제된다.

인스턴스 스토어 볼륨의 가상 디바이스에는 ephemeral0 ~ ephemeral23까지 순서대로 가상 디바이스 이름이 지정된다.

인스턴스 스토어는 aws 콘솔 > EC2 스토리지(EBS) 정보에 출력되지 않는다.

# 인스턴스 스토어 볼륨이 있는 c5 모든 타입의 스토리지 크기

aws ec2 describe-instance-types \

--filters "Name=instance-type,Values=c5*" "Name=instance-storage-supported,Values=true" \

--query "InstanceTypes[].[InstanceType, InstanceStorageInfo.TotalSizeInGB]" \

--output table

# 신규 노드 그룹 생성 전 정보 확인

eksctl create nodegroup --help

eksctl create nodegroup -c $CLUSTER_NAME -r ap-northeast-2 --subnet-ids "$PubSubnet1","$PubSubnet2","$PubSubnet3" --ssh-access \

-n ng2 -t c5d.large -N 1 -m 1 -M 1 --node-volume-size=30 --node-labels disk=instancestore --max-pods-per-node 100 --dry-run > myng2.yaml

cat <<EOT > nvme.yaml

preBootstrapCommands:

- |

# Install Tools

yum install nvme-cli links tree jq tcpdump sysstat -y

# Filesystem & Mount

mkfs -t xfs /dev/nvme1n1

mkdir /data

mount /dev/nvme1n1 /data

# Get disk UUID

uuid=\$(blkid -o value -s UUID mount /dev/nvme1n1 /data)

# Mount the disk during a reboot

echo /dev/nvme1n1 /data xfs defaults,noatime 0 2 >> /etc/fstab

EOT

sed -i -n -e '/volumeType/r nvme.yaml' -e '1,$p' myng2.yaml

#

export PubSubnet1=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet1" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet2=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet2" --query "Subnets[0].[SubnetId]" --output text)

export PubSubnet3=$(aws ec2 describe-subnets --filters Name=tag:Name,Values="$CLUSTER_NAME-Vpc1PublicSubnet3" --query "Subnets[0].[SubnetId]" --output text)

echo $PubSubnet1 $PubSubnet2 $PubSubnet3

#

SSHKEYNAME=<각자 자신의 SSH Keypair 이름>

SSHKEYNAME=imcr

- myng2.yaml 파일

cat << EOF > myng2.yaml

apiVersion: eksctl.io/v1alpha5

kind: ClusterConfig

metadata:

name: myeks

region: ap-northeast-2

version: "1.31"

managedNodeGroups:

- amiFamily: AmazonLinux2

desiredCapacity: 1

instanceType: c5d.large

labels:

alpha.eksctl.io/cluster-name: myeks

alpha.eksctl.io/nodegroup-name: ng2

disk: instancestore

maxPodsPerNode: 110

maxSize: 1

minSize: 1

name: ng2

ssh:

allow: true

publicKeyName: $SSHKEYNAME

subnets:

- $PubSubnet1

- $PubSubnet2

- $PubSubnet3

tags:

alpha.eksctl.io/nodegroup-name: ng2

alpha.eksctl.io/nodegroup-type: managed

volumeIOPS: 3000

volumeSize: 30

volumeThroughput: 125

volumeType: gp3

preBootstrapCommands:

- |

# Install Tools

yum install nvme-cli links tree jq tcpdump sysstat -y

# Filesystem & Mount

mkfs -t xfs /dev/nvme1n1

mkdir /data

mount /dev/nvme1n1 /data

# Get disk UUID

uuid=\$(blkid -o value -s UUID mount /dev/nvme1n1 /data)

# Mount the disk during a reboot

echo /dev/nvme1n1 /data xfs defaults,noatime 0 2 >> /etc/fstab

EOF

- 신규 노드 그룹 생성

# 신규 노드 그룹 생성

eksctl create nodegroup -f myng2.yaml

# 확인

kubectl get node --label-columns=node.kubernetes.io/instance-type,eks.amazonaws.com/capacityType,topology.kubernetes.io/zone

kubectl get node -l disk=instancestore

# ng2 노드 그룹 *ng2-remoteAccess* 포함된 보안그룹 ID

aws ec2 describe-security-groups --filters "Name=group-name,Values=*ng2-remoteAccess*" | jq

export NG2SGID=$(aws ec2 describe-security-groups --filters "Name=group-name,Values=*ng2-remoteAccess*" --query 'SecurityGroups[*].GroupId' --output text)

aws ec2 authorize-security-group-ingress --group-id $NG2SGID --protocol '-1' --cidr $(curl -s ipinfo.io/ip)/32

aws ec2 authorize-security-group-ingress --group-id $NG2SGID --protocol '-1' --cidr 172.20.1.100/32

# 워커 노드 SSH 접속

N4=<각자 자신의 워커 노드4번 공인 IP 지정>

N4=3.37.44.222

ssh ec2-user@$N4 hostname

# 확인

ssh ec2-user@$N4 sudo nvme list

ssh ec2-user@$N4 sudo lsblk -e 7 -d

ssh ec2-user@$N4 sudo df -hT -t xfs

ssh ec2-user@$N4 sudo tree /data

ssh ec2-user@$N4 sudo cat /etc/fstab

# (옵션) max-pod 확인

kubectl describe node -l disk=instancestore | grep Allocatable: -A7

# (옵션) kubelet 데몬 파라미터 확인 : --max-pods=29 --max-pods=110

ssh ec2-user@$N4 cat /etc/eks/bootstrap.sh

ssh ec2-user@$N4 sudo ps -ef | grep kubelet

root 3012 1 0 06:54 ? 00:00:06 /usr/bin/kubelet --config /etc/kubernetes/kubelet/kubelet-config.json --kubeconfig /var/lib/kubelet/kubeconfig --container-runtime-endpoint unix:///run/containerd/containerd.sock --image-credential-provider-config /etc/eks/image-credential-provider/config.json --image-credential-provider-bin-dir /etc/eks/image-credential-provider --node-ip=192.168.2.96 --pod-infra-container-image=602401143452.dkr.ecr.ap-northeast-2.amazonaws.com/eks/pause:3.5 --v=2 --hostname-override=ip-192-168-2-96.ap-northeast-2.compute.internal --cloud-provider=external --node-labels=eks.amazonaws.com/sourceLaunchTemplateVersion=1,alpha.eksctl.io/cluster-name=myeks,alpha.eksctl.io/nodegroup-name=ng2,disk=instancestore,eks.amazonaws.com/nodegroup-image=ami-0fa05db9e3c145f63,eks.amazonaws.com/capacityType=ON_DEMAND,eks.amazonaws.com/nodegroup=ng2,eks.amazonaws.com/sourceLaunchTemplateId=lt-013d691fc2310bba9 --max-pods=29 --max-pods=110

- local-path 스토리지 클래스 재생성 후 패스 변경

# 기존 local-path 스토리지 클래스 삭제

kubectl delete -f https://raw.githubusercontent.com/rancher/local-path-provisioner/v0.0.31/deploy/local-path-storage.yaml

# 새로운 local-path 스토리지 클래스 생성 (경로 변경)

curl -sL https://raw.githubusercontent.com/rancher/local-path-provisioner/v0.0.31/deploy/local-path-storage.yaml | sed 's/opt/data/g' | kubectl apply -f -

kubectl describe cm -n local-path-storage local-path-config

약 7배 정도 빠르다.

# [운영서버 EC2] Read 측정

kubestr fio -f fio-read.fio -s local-path --size 10G --nodeselector disk=instancestore

6. 노드 그룹

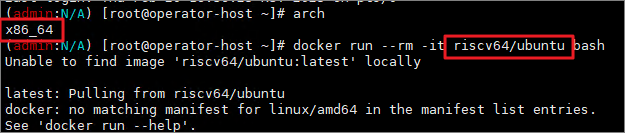

[사전 지식] - Multi (or Cross) Platform 빌드

우분투 컨테이너 이미지는 여러 아키텍처를 지원한다.

만약, ubuntu 컨테이너의 cpu 아키텍쳐와 호스트 cpu의 아키텍처가 다르면 도커 빌드가 불가능하다.

* docker buildx : cpu 아키텍쳐가 다른 멀티(or 크로스) 플랫폼에서도 빌드가 가능하다. (에뮬레이션을 사용하기 때문에 지연이 발생하긴 함)

# docker buildx 활성화 (멀티 아키텍처 빌드를 위해 필요)

docker run --rm --privileged multiarch/qemu-user-static --reset -p yes

docker images

docker buildx create --use --name mybuilder

docker buildx ls

[실습 환경 구축] 컨테이너 이미지 빌드 및 실행

#

mkdir myweb && cd myweb

# server.py 파일 작성

cat > server.py <<EOF

from http.server import ThreadingHTTPServer, BaseHTTPRequestHandler

from datetime import datetime

import socket

class RequestHandler(BaseHTTPRequestHandler):

def do_GET(self):

self.send_response(200)

self.send_header('Content-type', 'text/plain')

self.end_headers()

now = datetime.now()

hostname = socket.gethostname()

response_string = now.strftime("The time is %-I:%M:%S %p, VERSION 0.0.1\n")

response_string += f"Server hostname: {hostname}\n"

self.wfile.write(bytes(response_string, "utf-8"))

def startServer():

try:

server = ThreadingHTTPServer(('', 80), RequestHandler)

print("Listening on " + ":".join(map(str, server.server_address)))

server.serve_forever()

except KeyboardInterrupt:

server.shutdown()

if __name__ == "__main__":

startServer()

EOF

# Dockerfile 생성

cat > Dockerfile <<EOF

FROM python:3.12

ENV PYTHONUNBUFFERED 1

COPY . /app

WORKDIR /app

CMD python3 server.py

EOF

# 빌드, 실행 후 삭제

docker pull python:3.12

docker build -t myweb:1 -t myweb:latest .

docker images

docker run -d -p 8080:80 --name=timeserver myweb

curl http://localhost:8080

docker rm -f timeserver

# 멀티 플랫폼 빌드 후 푸시

docker images

docker login

DOCKERNAME=<도커허브 계정명>

DOCKERNAME=zgz111

# amd64, arm64로 컨테이너 이미지 만들기

docker buildx build --platform linux/amd64,linux/arm64 --push --tag $DOCKERNAME/myweb:multi .

docker images

docker manifest inspect $DOCKERNAME/myweb:multi | jq

docker buildx imagetools inspect $DOCKERNAME/myweb:multi

# 컨테이너 실행 해보기 : 윈도우PC(amd64)와 macOS(arm64) 두 곳 모두 동일한 컨테이너 이미지 경로로 실행해보자!

docker ps

docker run -d -p 8080:80 --name=timeserver $DOCKERNAME/myweb:multi

docker ps

# 컨테이너 접속 및 로그 확인

curl http://localhost:8080

docker logs timeserver

# 컨테이너 이미지 내부에 파일 확인

docker exec -it timeserver ls -l

# 컨테이너 이미지 내부에 server.py 파일 확인

docker exec -it timeserver cat server.py

# 컨테이너 삭제

docker rm -f timeserver

[AWS ECR 프라이빗 저장소 사용]

#

export ACCOUNT_ID=$(aws sts get-caller-identity --query 'Account' --output text)

aws ecr get-login-password \

--region ap-northeast-2 | docker login \

--username AWS \

--password-stdin ${ACCOUNT_ID}.dkr.ecr.ap-northeast-2.amazonaws.com

cat /root/.docker/config.json | jq

# ECR 프라이빗 저장소 생성

aws ecr create-repository --repository-name myweb

# ECR 프라이빗 저장소에 푸시

docker buildx build --platform linux/amd64,linux/arm64 --push --tag ${ACCOUNT_ID}.dkr.ecr.ap-northeast-2.amazonaws.com/myweb:multi .

docker images

# 컨테이너 실행 : 윈도우PC(amd64)와 macOS(arm64) 두 곳 모두 동일한 컨테이너 이미지 경로로 실행해보자!

docker run -d -p 8080:80 --name=timeserver ${ACCOUNT_ID}.dkr.ecr.ap-northeast-2.amazonaws.com/myweb:multi

docker ps

curl http://localhost:8080

# 컨테이너 삭제

docker rm -f timeserver

[ARM 노드 그룹]

- AWS Gravition (ARM) Instance : AWS Gravition 프로세서는 64bit Arm 프로세서 코어 기반의 AWS 커스텀 반도체 (20~40 % 향상된 가격 대비 성능을 제공한다.)

- 실습을 위해 신규 노드 그룹 n3 배포하기

#

kubectl get nodes -L kubernetes.io/arch

# 신규 노드 그룹 생성

eksctl create nodegroup --help

eksctl create nodegroup -c $CLUSTER_NAME -r ap-northeast-2 --subnet-ids "$PubSubnet1","$PubSubnet2","$PubSubnet3" \

-n ng3 -t t4g.medium -N 1 -m 1 -M 1 --node-volume-size=30 --node-labels family=graviton --dry-run > myng3.yaml

cat myng3.yaml

eksctl create nodegroup -f myng3.yaml

# 확인

kubectl get nodes --label-columns eks.amazonaws.com/nodegroup,kubernetes.io/arch,eks.amazonaws.com/capacityType

kubectl describe nodes --selector family=graviton

aws eks describe-nodegroup --cluster-name $CLUSTER_NAME --nodegroup-name ng3 | jq .nodegroup.taints

# taints 셋팅 -> 적용에 2~3분 정도 시간 소요

aws eks update-nodegroup-config --cluster-name $CLUSTER_NAME --nodegroup-name ng3 --taints "addOrUpdateTaints=[{key=frontend, value=true, effect=NO_EXECUTE}]"

# 확인

kubectl describe nodes --selector family=graviton | grep Taints

aws eks describe-nodegroup --cluster-name $CLUSTER_NAME --nodegroup-name ng3 | jq .nodegroup.taints

# NO_SCHEDULE - This corresponds to the Kubernetes NoSchedule taint effect. This configures the managed node group with a taint that repels all pods that don't have a matching toleration. All running pods are not evicted from the manage node group's nodes.

# NO_EXECUTE - This corresponds to the Kubernetes NoExecute taint effect. Allows nodes configured with this taint to not only repel newly scheduled pods but also evicts any running pods without a matching toleration.

# PREFER_NO_SCHEDULE - This corresponds to the Kubernetes PreferNoSchedule taint effect. If possible, EKS avoids scheduling Pods that do not tolerate this taint onto the node.

- Run pods on Graviton

# pod 배포

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: busybox

spec:

terminationGracePeriodSeconds: 3

containers:

- name: busybox

image: busybox

command:

- "/bin/sh"

- "-c"

- "while true; do date >> /home/pod-out.txt; cd /home; sync; sync; sleep 10; done"

tolerations:

- effect: NoExecute

key: frontend

operator: Exists

nodeSelector:

family: graviton

EOF

# 파드가 배포된 노드 정보 확인

kubectl get pod -owide

kubectl describe pod busybox

kubectl exec -it busybox -- arch

kubectl exec -it busybox -- tail -f /home/pod-out.txt

- 운영서버 ec2에서 빌드한 myweb 컨테이너 이미지를 pod로 배포해보기 !

# 아래 gasida 부분은 자신의 도커 허브 계정명으로 변경하거나 혹은 AWS ECR 프라이빗 저장소 경로로 변경해서 배포해보자

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: myweb-arm

spec:

terminationGracePeriodSeconds: 3

containers:

- name: myweb

image: gasida/myweb:multi

tolerations:

- effect: NoExecute

key: frontend

operator: Exists

nodeSelector:

family: graviton

---

apiVersion: v1

kind: Pod

metadata:

name: myweb-amd

spec:

terminationGracePeriodSeconds: 3

containers:

- name: myweb

image: zgz111/myweb:multi

EOF

#

kubectl get pod -owide

kubectl exec -it myweb-arm -- arch

kubectl exec -it myweb-amd -- arch

kubectl exec -it myweb-arm -- curl localhost

kubectl exec -it myweb-amd -- curl localhost

# 삭제

kubectl delete pod myweb-arm myweb-amd

[spot 노드 그룹]

- AWS의 EC2 여유 용량 pool을 활용해 엄청난 할인가로 EC2를 실행할 수 있다.

- spot instances가 중단될 때 2분 전에 알람을 받는다.

- Kubernetes 워커 노드로 Spot Instances를 사용하는 것은 상태 비저장 API 엔드포인트, 일괄 처리, ML 학습 워크로드, Apache Spark를 사용한 빅데이터 ETL, 대기열 처리 애플리케이션, CI/CD 파이프라인과 같은 워크로드에 많이 사용한다.

- 예를 들어 Kubernetes에서 상태 비저장 API 서비스를 실행하는 것은 Spot Instances를 워커 노드로 사용하기에 매우 적합하다. Pod를 우아하게 종료할 수 있고 Spot Instances가 중단되면 다른 워커 노드에서 대체 Pod를 예약할 수 있기 때문.

- instance selector 설치

# [운영서버 EC2] ec2-instance-selector 설치

curl -Lo ec2-instance-selector https://github.com/aws/amazon-ec2-instance-selector/releases/download/v2.4.1/ec2-instance-selector-`uname | tr '[:upper:]' '[:lower:]'`-amd64 && chmod +x ec2-instance-selector

mv ec2-instance-selector /usr/local/bin/

ec2-instance-selector --version

# 적절한 인스턴스 스펙 선택을 위한 도구 사용

ec2-instance-selector --vcpus 2 --memory 4 --gpus 0 --current-generation -a x86_64 --deny-list 't.*' --output table-wide

- spot 인스턴스 노드그룹 만들기

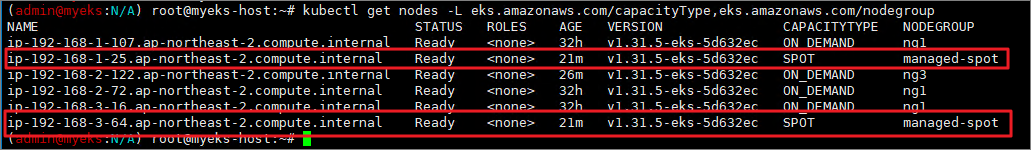

#

kubectl get nodes -l eks.amazonaws.com/capacityType=ON_DEMAND

kubectl get nodes -L eks.amazonaws.com/capacityType

# 노드 그룹 생성

NODEROLEARN=$(aws iam list-roles --query "Roles[?contains(RoleName, 'nodegroup-ng1')].Arn" --output text)

echo $NODEROLEARN

aws eks create-nodegroup \

--cluster-name $CLUSTER_NAME \

--nodegroup-name managed-spot \

--subnets $PubSubnet1 $PubSubnet2 $PubSubnet3 \

--node-role $NODEROLEARN \

--instance-types c5.large c5d.large c5a.large \

--capacity-type SPOT \

--scaling-config minSize=2,maxSize=3,desiredSize=2 \

--disk-size 20

# The command can be used to wait until a specific EKS node group is active and ready for use.

aws eks wait nodegroup-active --cluster-name $CLUSTER_NAME --nodegroup-name managed-spot

# 확인

kubectl get nodes -L eks.amazonaws.com/capacityType,eks.amazonaws.com/nodegroup

- spot 인스턴스에서 워크로드 실행하기

#

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: busybox

spec:

terminationGracePeriodSeconds: 3

containers:

- name: busybox

image: busybox

command:

- "/bin/sh"

- "-c"

- "while true; do date >> /home/pod-out.txt; cd /home; sync; sync; sleep 10; done"

nodeSelector:

eks.amazonaws.com/capacityType: SPOT

EOF

# 파드가 배포된 노드 정보 확인

kubectl get pod -owide

# 삭제

kubectl delete pod busybox

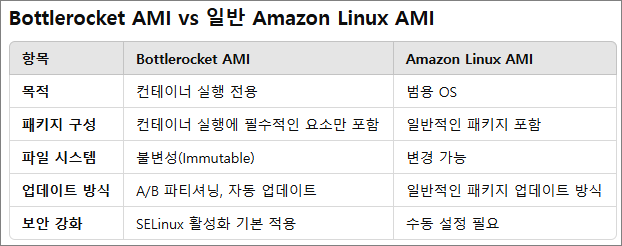

[Bottlerocket AMI]

Bottlerocket AMI는 AWS에서 개발한 Bottlerocket OS 기반의 Amazon Machine Image(AMI)이다.

Bottlerocket은 컨테이너 워크로드를 실행하는 데 최적화된 경량 Linux 기반 OS로, 기본적으로 Kubernetes와 같은 컨테이너 오케스트레이션 시스템에서 사용하도록 설계되었다.

불필요한 패키지가 설치되어 있지 않고 일반 이미지보다 보안이 강화되어있다.

- Bottlerocket AMI의 특징

1) 컨테이너 최적화

일반적인 Linux 배포판과 달리, 컨테이너 실행만을 목적으로 설계됨

불필요한 패키지 제거로 보안 강화 및 성능 최적화

2) 안정적인 자동 업데이트

A/B 파티셔닝을 활용한 이중화 업데이트(atomic update)

업데이트 후 롤백 기능 지원

3) Immutable(불변성) 파일 시스템

시스템 무결성을 유지하여 보안 위협 감소

불필요한 변경 방지로 운영 안정성 향상

4) AWS 서비스와 통합 지원

Amazon EKS(Kubernetes) 및 Amazon ECS 최적화

AWS Systems Manager(SSM)로 원격 관리 가능

5) SELinux 기반 강화된 보안

최소한의 사용자 공간 프로그램

SELinux(보안 모듈) 활성화

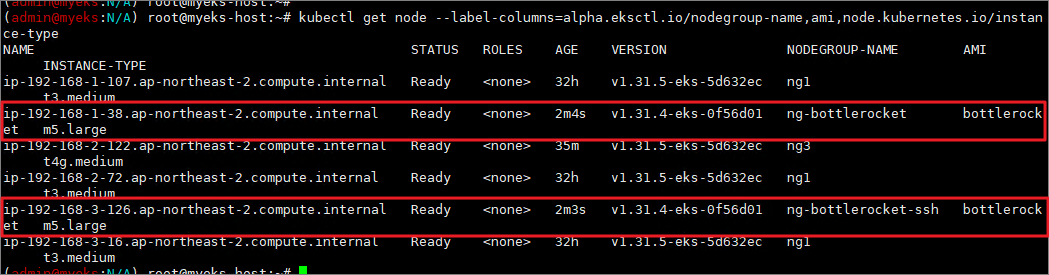

-노드 그룹 생성 및 노드 접속

* yaml 파일 작성

cat << EOF > ng-br.yaml

apiVersion: eksctl.io/v1alpha5

kind: ClusterConfig

metadata:

name: myeks

region: ap-northeast-2

version: "1.31"

managedNodeGroups:

- name: ng-bottlerocket

instanceType: m5.large

amiFamily: Bottlerocket

bottlerocket:

enableAdminContainer: true

settings:

motd: "Hello, eksctl!"

desiredCapacity: 1

maxSize: 1

minSize: 1

labels:

alpha.eksctl.io/cluster-name: myeks

alpha.eksctl.io/nodegroup-name: ng-bottlerocket

ami: bottlerocket

subnets:

- $PubSubnet1

- $PubSubnet2

- $PubSubnet3

tags:

alpha.eksctl.io/nodegroup-name: ng-bottlerocket

alpha.eksctl.io/nodegroup-type: managed

- name: ng-bottlerocket-ssh

instanceType: m5.large

amiFamily: Bottlerocket

desiredCapacity: 1

maxSize: 1

minSize: 1

ssh:

allow: true

publicKeyName: $SSHKEYNAME

labels:

alpha.eksctl.io/cluster-name: myeks

alpha.eksctl.io/nodegroup-name: ng-bottlerocket-ssh

ami: bottlerocket

subnets:

- $PubSubnet1

- $PubSubnet2

- $PubSubnet3

tags:

alpha.eksctl.io/nodegroup-name: ng-bottlerocket-ssh

alpha.eksctl.io/nodegroup-type: managed

EOF

* 노드 그룹 배포

#

cat ng-br.yaml

eksctl create nodegroup -f ng-br.yaml

# 노드의 OS 와 CRI 정보 등 확인

kubectl get node --label-columns=alpha.eksctl.io/nodegroup-name,ami,node.kubernetes.io/instance-type

kubectl get node -owide

# 인스턴스 IP 확인

aws ec2 describe-instances --query "Reservations[*].Instances[*].{InstanceID:InstanceId, PublicIPAdd:PublicIpAddress, PrivateIPAdd:PrivateIpAddress, InstanceName:Tags[?Key=='Name']|[0].Value, Status:State.Name}" --filters Name=instance-state-name,Values=running --output table

#

BRNode1=<ng-bottlerocket EC2 유동공인 IP>

BRNode2=<ng-bottlerocket-ssh EC2 유동공인 IP>

'Cloud > Kubernetes' 카테고리의 다른 글

| [AEWS3기] 4주차 EKS Observability (0) | 2025.02.27 |

|---|---|

| [AEWS3기] 2주차 - EKS Networking (2) (0) | 2025.02.14 |

| [AEWS3기] 2주차 - EKS Networking (1) (0) | 2025.02.13 |

| [AEWS3기] 1주차 - Amazon EKS 설치 및 기본 사용 (4) (0) | 2025.02.08 |

| [AEWS3기] 1주차 - Amazon EKS 설치 및 기본 사용 (3) (0) | 2025.02.05 |